笔记本部署大模型的步骤是什么?

- 电器维修

- 2025-03-19

- 16

随着人工智能技术的日益成熟,越来越多的研究者和开发者希望在个人设备上部署和运行大模型。笔记本由于其便携性和相对较高的性能,成为了一个不错的选择。但是,由于大模型对计算资源的需求很高,部署过程可能会遇到一些挑战。本文将详细介绍在笔记本上部署大模型的步骤,并提供一些实用的技巧和常见问题的解答,帮助大家顺利完成部署。

一、准备工作

确认笔记本的配置

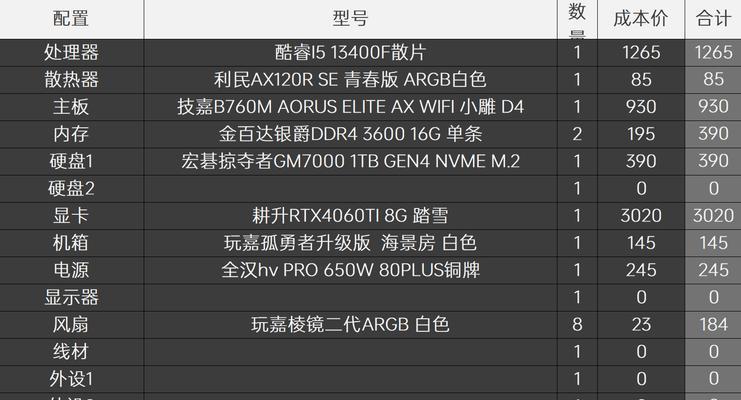

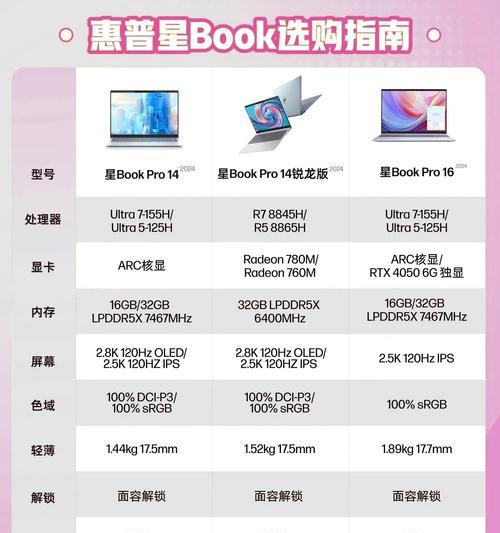

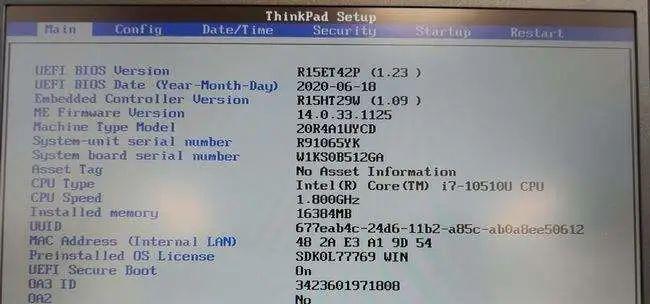

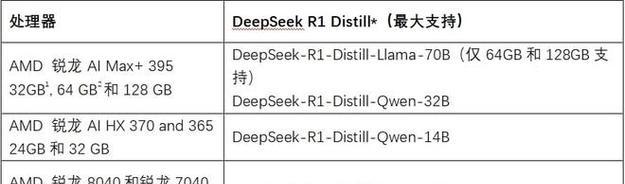

在开始部署之前,首先要确认你的笔记本具备足够的硬件资源。大模型通常需要强大的CPU和一个支持CUDA的NVIDIAGPU。同时,充足的RAM和高速的SSD也是必须的,以保证训练和推理的速度。

安装基础软件环境

安装操作系统,例如Win10/11或Linux发行版,然后安装以下软件环境:

CUDA:确保版本与你的GPU兼容。

cuDNN:CUDA的深度神经网络加速库。

Python:通常选择3.x版本。

Conda或Pip:用于安装Python包的工具。

可以使用命令行来安装这些软件,在Linux上使用命令`sudoaptinstallpython3python3-pip`。

二、安装深度学习框架

选择合适的深度学习框架

目前流行的深度学习框架包括TensorFlow、PyTorch等。这些框架一般都支持大模型的部署。以下是安装PyTorch的示例命令:

```bash

pip3installtorchtorchvisiontorchaudio

```

安装其他必要工具

除了深度学习框架,可能还需要安装一些辅助工具,如JupyterNotebook用于编写和测试代码,Git用于版本控制等。

```bash

pip3installjupytergit

```

三、下载和准备模型

选择大模型并下载

可以挑选预训练好的模型,如BERT、GPT等。通常,这些模型可以在其官方网站或GitHub仓库中找到。使用Git命令或直接下载模型文件。例如:

```bash

gitclonehttps://github.com/google-research/bert.git

```

检查模型兼容性

在运行模型之前,确保它与当前环境兼容。检查模型的依赖库版本是否与你的系统中安装的版本相匹配。

四、优化笔记本性能

调整电源设置

为了获得最佳性能,应将电源计划设置为“高性能”模式,并关闭不必要的后台程序和服务。

调整资源分配

在训练模型时,可以手动分配显存和内存,避免自动管理带来的资源浪费。

五、运行和测试模型

运行模型

根据模型文档,运行模型训练或推理的命令。注意,第一次运行可能需要较长时间,因为框架会进行一些初始化工作。

测试模型性能

评估模型的性能,观察是否达到预期效果。这可能涉及准确度测试、反应时间等。

六、与进阶

以上步骤,笔记本部署大模型涉及硬件确认、软件安装、深度学习框架设置、模型下载与优化、性能调整和最终测试。在实施过程中,可能会面临各种挑战,但只要按照步骤仔细执行,就能顺利完成部署。

常见问题解答

1.笔记本配置不够怎么办?

如果硬件配置不足以支持大模型,可以考虑使用云服务平台或升级硬件。

2.如何解决安装过程中遇到的依赖问题?

确保所有前置条件都已满足,并检查是否有包版本冲突。

3.如何进一步提高模型性能?

可以尝试优化代码、调整模型结构或者使用更高级的硬件。

实用技巧

使用虚拟环境管理不同的项目,避免包版本冲突。

了解并使用模型的剪枝、量化等优化技术减少资源需求。

定期备份数据和模型,防止意外丢失。

综合以上,部署大模型到笔记本是一项复杂但可行的工作,需要耐心和细致的步骤执行。希望你通过本文的指导,能够顺利地在你的笔记本上开展深度学习项目。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。!

本文链接:https://www.9jian.net/article-8272-1.html